iOS cvimagebuffer zniekształcony z Avcapturessiondataoutput z Avcapturessionpresetphoto

Na wysokim poziomie, stworzy┼éem aplikacj─Ö, kt├│ra pozwala u┼╝ytkownikowi skierowa─ć kamer─Ö iPhone wok├│┼é i zobaczy─ć klatki wideo, kt├│re zosta┼éy przetworzone z efektami wizualnymi. Ponadto u┼╝ytkownik mo┼╝e stukn─ģ─ć przycisk, aby zrobi─ć zamro┼╝on─ģ ramk─Ö bie┼╝─ģcego podgl─ģdu jako zdj─Öcie w wysokiej rozdzielczo┼øci, kt├│re jest zapisane w bibliotece iPhone ' a.

Aby to zrobi─ć, aplikacja post─Öpuje zgodnie z t─ģ procedur─ģ:

1) Utw├│rz avcapturession

captureSession = [[AVCaptureSession alloc] init];

[captureSession setSessionPreset:AVCaptureSessionPreset640x480];

2) Pod┼é─ģcz AVCaptureDeviceInput za pomoc─ģ kamera zwr├│cona w ty┼é.

videoInput = [[[AVCaptureDeviceInput alloc] initWithDevice:backFacingCamera error:&error] autorelease];

[captureSession addInput:videoInput];

3) Pod┼é─ģcz interfejs Avcaptustillimageoutput do sesji, aby m├│c przechwytywa─ć nieruchome klatki w rozdzielczo┼øci zdj─Ö─ć.

stillOutput = [[AVCaptureStillImageOutput alloc] init];

[stillOutput setOutputSettings:[NSDictionary

dictionaryWithObject:[NSNumber numberWithInt:kCVPixelFormatType_32BGRA]

forKey:(id)kCVPixelBufferPixelFormatTypeKey]];

[captureSession addOutput:stillOutput];

4) Pod┼é─ģcz AVCaptureVideoDataOutput do sesji, aby m├│c przechwytywa─ć pojedyncze klatki wideo (Cvimagebuffery) w ni┼╝szej rozdzielczo┼øci

videoOutput = [[AVCaptureVideoDataOutput alloc] init];

[videoOutput setVideoSettings:[NSDictionary dictionaryWithObject:[NSNumber numberWithInt:kCVPixelFormatType_32BGRA] forKey:(id)kCVPixelBufferPixelFormatTypeKey]];

[videoOutput setSampleBufferDelegate:self queue:dispatch_get_main_queue()];

[captureSession addOutput:videoOutput];

5) gdy klatki wideo s─ģ przechwytywane, metoda delegata jest wywo┼éywana z ka┼╝d─ģ now─ģ klatk─ģ jako CVImageBuffer:

- (void)captureOutput:(AVCaptureOutput *)captureOutput didOutputSampleBuffer:(CMSampleBufferRef)sampleBuffer fromConnection:(AVCaptureConnection *)connection

{

CVImageBufferRef pixelBuffer = CMSampleBufferGetImageBuffer(sampleBuffer);

[self.delegate processNewCameraFrame:pixelBuffer];

}

6) Nast─Öpnie delegat przetwarza / rysuje oni:

- (void)processNewCameraFrame:(CVImageBufferRef)cameraFrame {

CVPixelBufferLockBaseAddress(cameraFrame, 0);

int bufferHeight = CVPixelBufferGetHeight(cameraFrame);

int bufferWidth = CVPixelBufferGetWidth(cameraFrame);

glClear(GL_COLOR_BUFFER_BIT);

glGenTextures(1, &videoFrameTexture_);

glBindTexture(GL_TEXTURE_2D, videoFrameTexture_);

glTexParameteri(GL_TEXTURE_2D, GL_TEXTURE_MIN_FILTER, GL_LINEAR);

glTexParameteri(GL_TEXTURE_2D, GL_TEXTURE_MAG_FILTER, GL_LINEAR);

glTexParameteri(GL_TEXTURE_2D, GL_TEXTURE_WRAP_S, GL_CLAMP_TO_EDGE);

glTexParameteri(GL_TEXTURE_2D, GL_TEXTURE_WRAP_T, GL_CLAMP_TO_EDGE);

glTexImage2D(GL_TEXTURE_2D, 0, GL_RGBA, bufferWidth, bufferHeight, 0, GL_BGRA, GL_UNSIGNED_BYTE, CVPixelBufferGetBaseAddress(cameraFrame));

glBindBuffer(GL_ARRAY_BUFFER, [self vertexBuffer]);

glBindBuffer(GL_ELEMENT_ARRAY_BUFFER, [self indexBuffer]);

glDrawElements(GL_TRIANGLE_STRIP, 4, GL_UNSIGNED_SHORT, BUFFER_OFFSET(0));

glBindBuffer(GL_ARRAY_BUFFER, 0);

glBindBuffer(GL_ELEMENT_ARRAY_BUFFER, 0);

[[self context] presentRenderbuffer:GL_RENDERBUFFER];

glDeleteTextures(1, &videoFrameTexture_);

CVPixelBufferUnlockBaseAddress(cameraFrame, 0);

}

Je┼øli jednak uchwyc─Ö zdj─Öcie z tej sesji, jego rozdzielczo┼ø─ć b─Ödzie r├│wnie┼╝ wynosi─ć 640x480. Chc─Ö, aby by┼éa to wysoka rozdzielczo┼ø─ć, wi─Öc w pierwszym kroku zmieniam wst─Öpnie ustawion─ģ lini─Ö na:

[captureSession setSessionPreset:AVCaptureSessionPresetPhoto];

To poprawnie rejestruje nieruchome obrazy w najwy┼╝szej rozdzielczo┼øci dla iPhone4 (2592x1936).

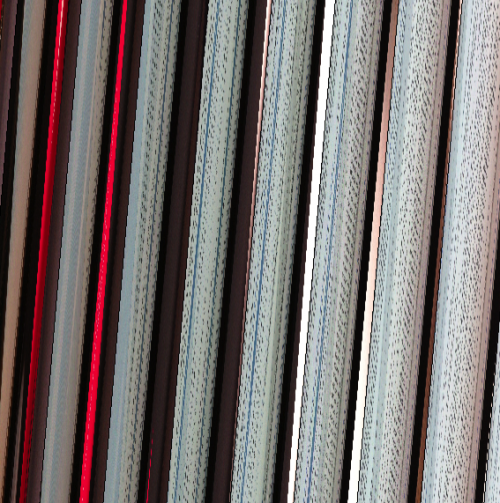

Jednak filmik podgl─ģd (otrzymany przez delegata w krokach 5 i 6) wygl─ģda teraz nast─Öpuj─ģco:

Potwierdzi┼éem, ┼╝e wszystkie inne ustawienia predefiniowane (High, medium, low, 640x480 i 1280x720) wy┼øwietlaj─ģ si─Ö zgodnie z przeznaczeniem. Jednak ustawienie wst─Öpne zdj─Öcia wydaje si─Ö wysy┼éa─ć dane bufora w innym formacie.

Potwierdzi┼éem r├│wnie┼╝, ┼╝e dane wysy┼éane do bufora w ustawieniu domy┼ølnym zdj─Öcia s─ģ w rzeczywisto┼øci poprawnymi danymi obrazu, pobieraj─ģc bufor i tworz─ģc z niego interfejs zamiast wysy┼éa─ć go do openGL:

CGColorSpaceRef colorSpace = CGColorSpaceCreateDeviceRGB();

CGContextRef context = CGBitmapContextCreate(CVPixelBufferGetBaseAddress(cameraFrame), bufferWidth, bufferHeight, 8, bytesPerRow, colorSpace, kCGBitmapByteOrder32Little | kCGImageAlphaPremultipliedFirst);

CGImageRef cgImage = CGBitmapContextCreateImage(context);

UIImage *anImage = [UIImage imageWithCGImage:cgImage];

Pokazuje niezak┼é├│con─ģ klatk─Ö wideo.

Przeprowadzi┼éem kilka poszukiwa┼ä i nie mog─Ö tego naprawi─ć. Mam przeczucie, ┼╝e to kwestia formatu danych. Oznacza to, ┼╝e uwa┼╝am, ┼╝e bufor jest ustawiony poprawnie, ale z formatem, kt├│rego ta linia nie rozumie:

glTexImage2D(GL_TEXTURE_2D, 0, GL_RGBA, bufferWidth, bufferHeight, 0, GL_BGRA, GL_UNSIGNED_BYTE, CVPixelBufferGetBaseAddress(cameraFrame));

Moje przeczucie by┼éo takie, ┼╝e zmiana zewn─Ötrznego formatu z GL_BGRA na co┼ø innego mo┼╝e pom├│c, ale tak nie jest... i przez r├│┼╝ne sposoby wygl─ģda na to, ┼╝e bufor jest rzeczywi┼øcie w GL_BGRA.

Czy kto┼ø wie, co tu si─Ö dzieje? A mo┼╝e masz jakie┼ø wskaz├│wki, jak Mog─Ö przej┼ø─ć do debugowania, dlaczego tak si─Ö dzieje? (Bardzo dziwne jest to, ┼╝e dzieje si─Ö to na iphone4, ale nie na iPhone 3GS ... oba uruchomione ios4. 3)8 answers

To było straszne.

Jak zauwa┼╝y┼é Lio Ben-Kereth, padding jest 48, jak wida─ć z debuggera

(gdb) po pixelBuffer

<CVPixelBuffer 0x2934d0 width=852 height=640 bytesPerRow=3456 pixelFormat=BGRA

# => 3456 - 852 * 4 = 48

OpenGL mo┼╝e to zrekompensowa─ć, ale OpenGL ES nie mo┼╝e (wi─Öcej informacji tutaj Podteksturowanie OpenGL)

Oto Jak to robi─Ö w OpenGL ES:

(CVImageBufferRef)pixelBuffer // pixelBuffer containing the raw image data is passed in

/* ... */

glActiveTexture(GL_TEXTURE0);

glBindTexture(GL_TEXTURE_2D, videoFrameTexture_);

int frameWidth = CVPixelBufferGetWidth(pixelBuffer);

int frameHeight = CVPixelBufferGetHeight(pixelBuffer);

size_t bytesPerRow, extraBytes;

bytesPerRow = CVPixelBufferGetBytesPerRow(pixelBuffer);

extraBytes = bytesPerRow - frameWidth*4;

GLubyte *pixelBufferAddr = CVPixelBufferGetBaseAddress(pixelBuffer);

if ( [[captureSession sessionPreset] isEqualToString:@"AVCaptureSessionPresetPhoto"] )

{

glTexImage2D( GL_TEXTURE_2D, 0, GL_RGBA, frameWidth, frameHeight, 0, GL_BGRA, GL_UNSIGNED_BYTE, NULL );

for( int h = 0; h < frameHeight; h++ )

{

GLubyte *row = pixelBufferAddr + h * (frameWidth * 4 + extraBytes);

glTexSubImage2D( GL_TEXTURE_2D, 0, 0, h, frameWidth, 1, GL_BGRA, GL_UNSIGNED_BYTE, row );

}

}

else

{

glTexImage2D(GL_TEXTURE_2D, 0, GL_RGBA, frameWidth, frameHeight, 0, GL_BGRA, GL_UNSIGNED_BYTE, pixelBufferAddr);

}

Wcze┼øniej u┼╝ywa┼éem AVCaptureSessionPresetMedium i otrzymywa┼éem 30fps. W AVCaptureSessionPresetPhoto dostaj─Ö 16fps na iPhone 4. Zap─Ötlenie sub-tekstury nie ma wp┼éywu na szybko┼ø─ć wy┼øwietlania klatek.

I ' m korzystanie z iPhone 4 na iOS 5.

Warning: date(): Invalid date.timezone value 'Europe/Kyiv', we selected the timezone 'UTC' for now. in /var/www/agent_stack/data/www/doraprojects.net/template/agent.layouts/content.php on line 54

2017-05-23 12:34:22

Po prostu narysuj tak.

size_t bytesPerRow = CVPixelBufferGetBytesPerRow(pixelBuffer);

int frameHeight = CVPixelBufferGetHeight(pixelBuffer);

GLubyte *pixelBufferAddr = CVPixelBufferGetBaseAddress(pixelBuffer);

glTexImage2D(GL_TEXTURE_2D, 0, GL_RGBA, (GLsizei)bytesPerRow / 4, (GLsizei)frameHeight, 0, GL_BGRA, GL_UNSIGNED_BYTE, pixelBufferAddr);

Warning: date(): Invalid date.timezone value 'Europe/Kyiv', we selected the timezone 'UTC' for now. in /var/www/agent_stack/data/www/doraprojects.net/template/agent.layouts/content.php on line 54

2012-04-01 03:19:00

Dobre maty punktowe. Ale w rzeczywisto┼øci wy┼øci├│┼éka jest wi─Öksza, to:

bytesPerRow = 4 * bufferWidth + 48;

Dzia┼éa ┼øwietnie na tylnym aparacie iphone 4 i rozwi─ģza┼é problem, o kt├│rym poinformowa┼é sotangochips.

Warning: date(): Invalid date.timezone value 'Europe/Kyiv', we selected the timezone 'UTC' for now. in /var/www/agent_stack/data/www/doraprojects.net/template/agent.layouts/content.php on line 54

2011-09-14 12:49:56

Dex, dzi─Öki za doskona┼é─ģ odpowied┼║. Aby uczyni─ć Tw├│j kod bardziej og├│lnym, zamieni┼ébym:

if ( [[captureSession sessionPreset] isEqualToString:@"AVCaptureSessionPresetPhoto"] )

Z

if ( extraBytes > 0 )

Warning: date(): Invalid date.timezone value 'Europe/Kyiv', we selected the timezone 'UTC' for now. in /var/www/agent_stack/data/www/doraprojects.net/template/agent.layouts/content.php on line 54

2011-11-06 22:53:05

Chyba znalaz┼éem twoj─ģ odpowied┼║ i przykro mi, bo to nie jest dobra wiadomo┼ø─ć.

Mo┼╝esz sprawdzi─ć ten link: http://developer.apple.com/library/mac/#documentation/AudioVideo/Conceptual/AVFoundationPG/Articles/04_MediaCapture.html

Konfigurowanie sesji

Symbol: Avcapturessionpresetphoto

Rozdzielczo┼ø─ć: Zdj─Öcie.

Uwagi: Pe┼éna rozdzielczo┼ø─ć zdj─Ö─ć. Nie jest to obs┼éugiwane dla wyj┼øcia wideo.

Warning: date(): Invalid date.timezone value 'Europe/Kyiv', we selected the timezone 'UTC' for now. in /var/www/agent_stack/data/www/doraprojects.net/template/agent.layouts/content.php on line 54

2011-11-11 22:14:10

The sessionPresetPhoto jest ustawieniem do przechwytywania zdj─Öcia o najwy┼╝szej jako┼øci. Kiedy u┼╝ywamy AVCaptureStillImageOutput z zaprogramowanym zdj─Öciem, ramka przechwycona ze strumienia wideo zawsze ma rozdzielczo┼ø─ć ekranu iPada lub iPhone ' a. Mia┼éem ten sam problem z iPadem Pro 12.9 cala, kt├│ry ma rozdzielczo┼ø─ć 2732 * 2048. Oznacza to, ┼╝e klatka, kt├│r─ģ przechwyci┼éem ze strumienia wideo, wynosi┼éa 2732 * 2048, ale zawsze by┼éa zniekszta┼écona i przesuni─Öta. Pr├│bowa┼éem wy┼╝ej wymienionych rozwi─ģza┼ä, ale nie rozwi─ģza┼éo to mojego problemu. W ko┼äcu zda┼éem sobie spraw─Ö, ┼╝e szeroko┼ø─ć ramki powinna by─ć zawsze podzielna na 8, kt├│rej 2732 nie jest. 2732/8 = 341.5. Obliczy┼éem wi─Öc modulo szeroko┼øci i 8. Je┼╝eli modulo nie jest r├│wne zeru to dodaj─Ö go do szeroko┼øci. W tym przypadku 2732% 8 = 4 i wtedy dostaj─Ö 2732+4 = 2736. Dlatego ustawi─Ö t─Ö szeroko┼ø─ć ramki w CVPixelBufferCreate, aby zainicjowa─ć m├│j pixelBuffer (CVPixelBufferRef).

Warning: date(): Invalid date.timezone value 'Europe/Kyiv', we selected the timezone 'UTC' for now. in /var/www/agent_stack/data/www/doraprojects.net/template/agent.layouts/content.php on line 54

2017-05-02 09:40:11

Bufor obrazu wydaje si─Ö zawiera─ć pewne wype┼énienia na ko┼äcu. Np.

bytesPerRow = 4 * bufferWidth + 12;

Jest to często wykonywane tak, aby każdy wiersz piksela zaczynał się od 16-bajtowego offsetu.

Warning: date(): Invalid date.timezone value 'Europe/Kyiv', we selected the timezone 'UTC' for now. in /var/www/agent_stack/data/www/doraprojects.net/template/agent.layouts/content.php on line 54

2011-08-29 16:34:26

U┼╝yj tego rozmiaru evereywhere w kodzie

int width_16 = (int)yourImage.size.width - (int)yourImage.size.width%16;

int height_ = (int)(yourImage.size.height/yourImage.size.width * width_16) ;

CGSize video_size_ = CGSizeMake(width_16, height_);

Warning: date(): Invalid date.timezone value 'Europe/Kyiv', we selected the timezone 'UTC' for now. in /var/www/agent_stack/data/www/doraprojects.net/template/agent.layouts/content.php on line 54

2018-07-05 04:40:48